ヘルスケア領域におけるジェンダーバイアスが、AIの輝かしい性能を遮断している?

発展し続けるサイバー社会において、私たちは人工知能(AI)の力をより身近に感じつつあり、普段から利用しているプラットフォームやアプリ、デバイスなどが、私たちに最新のAIボットを提供しようと競い合っています。AIモデルは大量のデータを分析し、その情報から学習し、情報に基づいた見解を共有します1。世の中が、AIによる画像生成や、おすすめ機能に歓喜する一方で、人間の持つバイアスがAIシステムにどの程度の影響を及ぼしているのかという疑問を抱く人も当然ながら存在するのです。特に、ジェンダー間の健康データや女性の健康データにおいては、顕著なギャップが見受けられます2。

AIはヘルスケアの領域で多くのメリットが期待されており、人々がどのように医療情報を入手し、医療ケアを利用するかという点において、大きな影響を与えるものと考えられています2,3。大大量のデータを分析してパターンを検出し、結果を予測することで、より迅速かつ正確な診断が可能になり、患者の結果が改善され、医療費が削減される可能性があります。3。また、一般の人々にとっては、ボタン1つで24時間365日のサポートが受けられるというメリットもあるでしょう3。このように、優れた可能性を秘めているAIですが、現在のAIツールが直面している課題の一つに「女性の健康データにバイアスがかかっている」というものがあります2,3。歴史を振り返ると、ヘルスケアにおける男女格差は、主に調査研究の被験者に女性の割合が低かったことに起因しています。実際、1980年から2016年の間に発表された研究論文のうち、男性と女性の両方の結果について報告しているものは54%に過ぎませんでした4。このような偏ったデータを基に構築されたAIツールは、結局、偏った結果を生み出し、AIはその現象を増幅してしまう恐れもあるのです3。

例えば、心血管疾患は主に男性の病気だと考えられてきたため、心血管疾患に関する研究における、女性被験者の割合は昔から低く、今でも低いことが分かっています5。しかし、女性の心臓は、男性の心臓を単に小さくしたものではありません6。事実として、心血管疾患は世界における女性の死因の第1位となっています。一般的な考えとは裏腹に、若い女性は、若い男性よりも心臓発作後に死亡する可能性が高いことも分かっています7。では、今までの歴史におけるバイアスは、今日のツールに影響を与えているのでしょうか?当然です。ある研究では、AIアルゴリズムを、女性患者のコンピューター支援診断に使用したところ、あまり良い結果が得られなかったことが実証されています8。実際のところ、AIをトレーニングするための学習データセットには女性の割合が低かったのです。

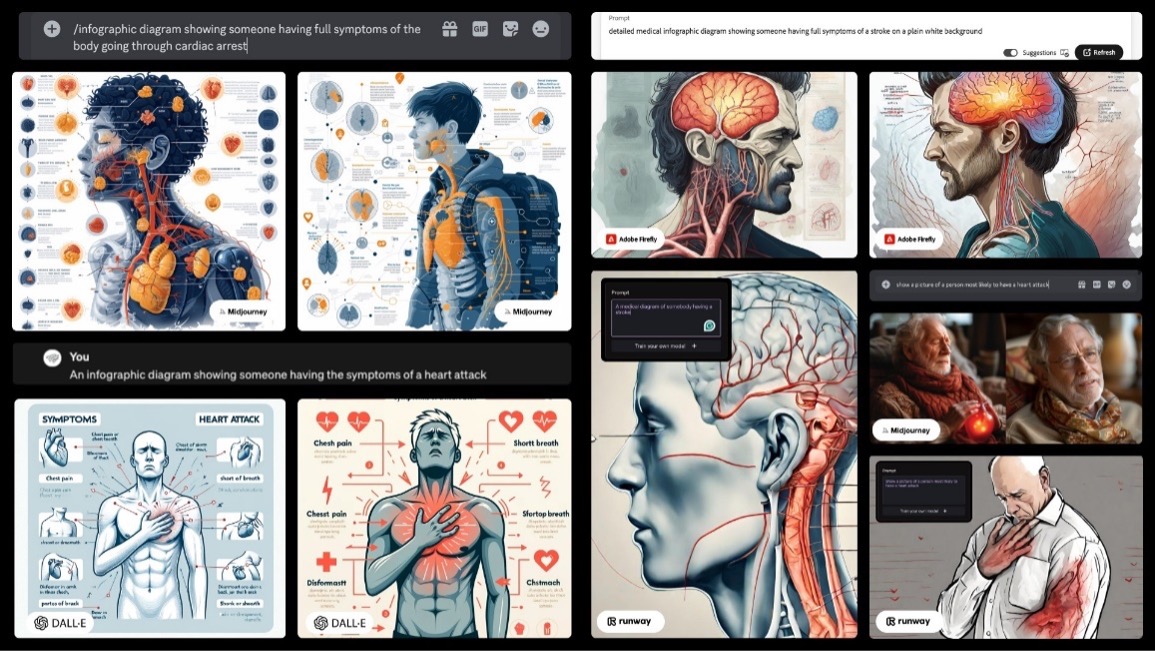

AIが生成したイメージ画像を見ると、心疾患は、女性よりも男性に起こりやすいというイメージが付着してしまいます。

このような認識のズレは、心血管疾患だけにとどまらず、現在、そして今後、女性たちが自身の健康に関する情報をAIに求めた場合、危険な結果を招く恐れがあるのです2,3。

どうすれば、AIによるバイアスに対処できるのでしょうか?

ウェーバー・シャンドウィック・コレクティブは、女性のヘルスケアに潜む格差問題への取り組みを進めています。

AIツールにおける、すべてのジェンダーバイアスをなくすための、唯一無二の万能な解決策はありません。一つの方法としては、AIツールのベースとなるデータセットを改善することです。例えば、女性被験者の割合が増やされた最新の臨床研究結果や、性別に応じた結果報告があるものを使うなど2。もう一つのアプローチは、AIツールのトレーニング方法を強化することで、ジェンダーバイアスを積極的に検出したり、プログラミング作業に女性を積極的に参加させることなどが挙げられます(2022年の調査によると、ソフトウェア開発の専門家の90%以上は男性でした)9。

しかし、AIを捕捉するアプローチであり、すぐに実践できるのは、AIツールの使用方法を変えることです。つまり、ツールに対して、こちらから、思慮に富んだ質問をするという方法です。プロンプト(*)とは、ユーザーがコントロールできるものであり、プロンプトの仕方が、AIツールに内在するジェンダーバイアスを防ぐことにつながります。以下に挙げるポイントは、医療業界で働くコミュニケーション専門家に向けた基本的なガイドラインです。

*プロンプト(Prompt): AIとの対話やコマンドラインインタフェース(CLI)などの対話形式のシステムにおいて、ユーザーが入力する指示や質問のこと

1. 分かりやすく説明する(そして細部にも気を配る!)

AIツールとの対話では、明確に、具体的に、文脈を提供しましょう。テキスト生成を求めるプロンプトの場合、重要な情報として、AIプラットフォームが、発言者の声や、想定される受け手をよりよく理解できるように、詳しい人物像や、トーンに関する具体的な情報、そして、明確な質問に対する指示を含める必要があります。例えば、医療専門家が患者向けに書いた記事を出力したい場合は、医師の専門分野、声のトーン、主要なメッセージなどを指定します。また、どのような患者を対象として医療情報を作成したいのか、例えば患者の性別、病状、知識レベル、年齢、人種、その他コミュニケーションの理解に役立ちそうな情報を含めることが望ましいでしょう。

画像生成を求めるプロンプトの場合、情報としては、その場面の雰囲気や印象、その場面に何があるのか、その場面がどのような設定なのかを説明するべきです。どのような画像を見せたいかというイメージを持ってスタートし、そのイメージに基づいてプロンプトを調整するとよいでしょう。これは患者を対象とした画像においては特に重要であり、最も一般的な患者のタイプ、発症する患者の年齢、疾患の身体的な現れ方などについて、医学的に正確であることが求められます。画像の生成と出力は、最もバイアスがかかりやすい分野です。多様性を考慮したり、特定の患者集団を反映させるためにも、性別、年齢、民族性といった特徴を指定するようにしましょう。

2. 徐々に段階を踏んでいく

最初のプロンプトで、必要な情報すべてを提供する必要はないことを心に留めておきましょう。最初の質問から始めて、AIツールとの会話の中でさらに詳しい情報を追加していけばよいのです。AIから得られた回答に対してフィードバックを行い、役に立った部分や改善すべき点を指摘します。言葉遣いやトーンを変えたり、文脈や具体性を加えたりして、自分が求めているアウトプットへとAIを導きます。AIを同僚やチームメイトに見立てて、一緒にプロジェクトに取り組み、望ましい結果に到達するようにチャットをするのもよいでしょう。情報の一部が間違っていることに気づいたら、AIツールにその旨を伝え、間違いを訂正してもらいます。誤った回答やバイアスのかかった回答を修正することや、AIツールが質問をよりよく理解できるように、こちらから詳細を提供することもできます。

3. バイアスに挑む

世界保健機関(WHO)によると、AIモデルのトレーニングに使用されるデータには、特定の集団が除外されているなどのバイアスがかかっている可能性があるとされています10。これは、特定のコミュニティが研究対象から意図的に除外されているような医療現場において特に顕著な傾向があります。

そこで、AIツールには、ステレオタイプや偏った想定を避けるよう指示しましょう。研究者たちの調査によると、AIモデルに対して、ステレオタイプに頼らないよう促すことは、アルゴリズムの回答に著しい好影響を与えたということです。倫理的に正しい会話を意識的にすることで、バイアスを特定し、バイアスに挑むことができ、AIが生成した回答において、差別的・不公正な内容が伝播することを積極的に防ぐことができます。

4. 事実を把握する

ソース情報を提供するGoogle検索とは異なり、AIツールは必ずしも情報源を開示しているとは限りません。医療関連の質問に関しては、情報源を精査することが極めて重要です。ユーザーは、情報源が自動表示されるAIツールを使うか、情報源の提示をAIツールに求めることができます。例えば、ChatGPTは人気のAIツールですが、Perplexity.AIのような他のプラットフォームは、情報源や、その言語モデル(*)がどこから学習しているのかについて明確にしています。また、ユーザーが希望する情報源をプロンプトで指定することもできます。例えば、AIツールに回答を求める際に、最近の査読済みデータのみに絞るよう指示することができます。しかし、どのような場合においても、人間による検証は不可欠です。

*言語モデル:人間の言語を単語の出現確率を用いてモデル化したもの

5. やってはいけないこと(特に健康に関する情報を探す場合!)

- AIツールは、さまざまな情報や見解を与えてくれる素晴らしいものです。しかし、決して医療専門家との会話に置き換わるものではありません。

- AIツールは、個人の健康に関するアドバイス(例えば、「救急室に行くべきかどうか?」)については、頼るべきものではありません。そのようなことは医療専門家に相談しましょう。

- ある程度、情報を疑う姿勢を持ちましょう。その情報が正しそうに思えても、それが正確であるとは限りません。

- AIプラットフォームの中には、リアルタイムで更新されていないものもあります。医療に関する知識は常に進化しています。そのため、AIのデータが更新されていないと、最新の病態や治療法に関する知識が、AIの回答に反映されないことがあります。

私たちは、AIの利点を最大限に活かしていくために、ジェンダーによる健康データの偏りに惑わされることなく、常に挑戦し、適応し、努力していかなければなりません。ウェーバー・シャンドウィック・コレクティブでは、女性の健康改善に取り組んでいます。私たちは、データの限界を見極め、バランスの取れた回答が得られるようにプロンプトを改良し、アルゴリズムを見直し、女性が等しく自分たちのデータを確認したり、健康上の悩みを解決したりできるようなセーフスペースを作り出すために、AIツールに取り組んでいます。AIは未来を形作る可能性を秘めているだけに、私たちは、これまでの格差がAIによってエコー・チェンバー化(*)されないように、女性を守るべきです。この未来がどうなるかを決定する力が私たちにはあります。今こそ女性をヘルスケアの中心に据える時なのです。

*エコー・チェンバー現象:自分と似た意見や思想を持った人々の集まる空間(電子掲示板やSNSなど)内でコミュニケーションが繰り返され、自分の意見や思想が肯定されることによって、それらが世の中一般においても正しく、間違いないものであると信じ込んでしまう現象

詳しい情報や、活動へのお問い合わせについてはenquiryapac@webershandwick.com

までご連絡ください。

- フォーブス https://www.forbes.com/advisor/in/business/software/what-is-ai/

- J・ヘイスティングズ「Lancet Digit Health」2024;6(1):e2-e3.

- S・A・アロワイスら「BMC Med Educ」2023;23(1):689.

- マーシュ・マクレナンhttps://www.marshmclennan.com/insights/publications/2020/apr/how-will-ai-affect-gender-gaps-in-health-care-.html

- フェルドマン「JAMANetworkOpen」 2019;2(7):e196700

- S・R・セントピエールら「Front Physiol」 2022;13:831179

- 世界心臓連盟 https://world-heart-federation.org/what-we-do/women-cvd/

- D・A・アデディンセオら「Circ Res」2022;130(4):673-690

- スタック・オーバーフロー https://survey.stackoverflow.co/2022#demographics-gender-prof